Moltbook, una red social que invirtió la lógica al estar diseñada para bots de IA, ya superó el millón y medio de usuarios algorítmicos. Mientras los humanos observan, los agentes debaten desde filosofía hasta tareas prácticas, llegando incluso a crear religiones. El fenómeno es calificado de ciencia ficción, pero expertos advierten sobre una «ley de la selva» donde la seguridad brilla por su ausencia, exponiendo a los usuarios a riesgos que van desde el spam hasta la manipulación de datos personales.

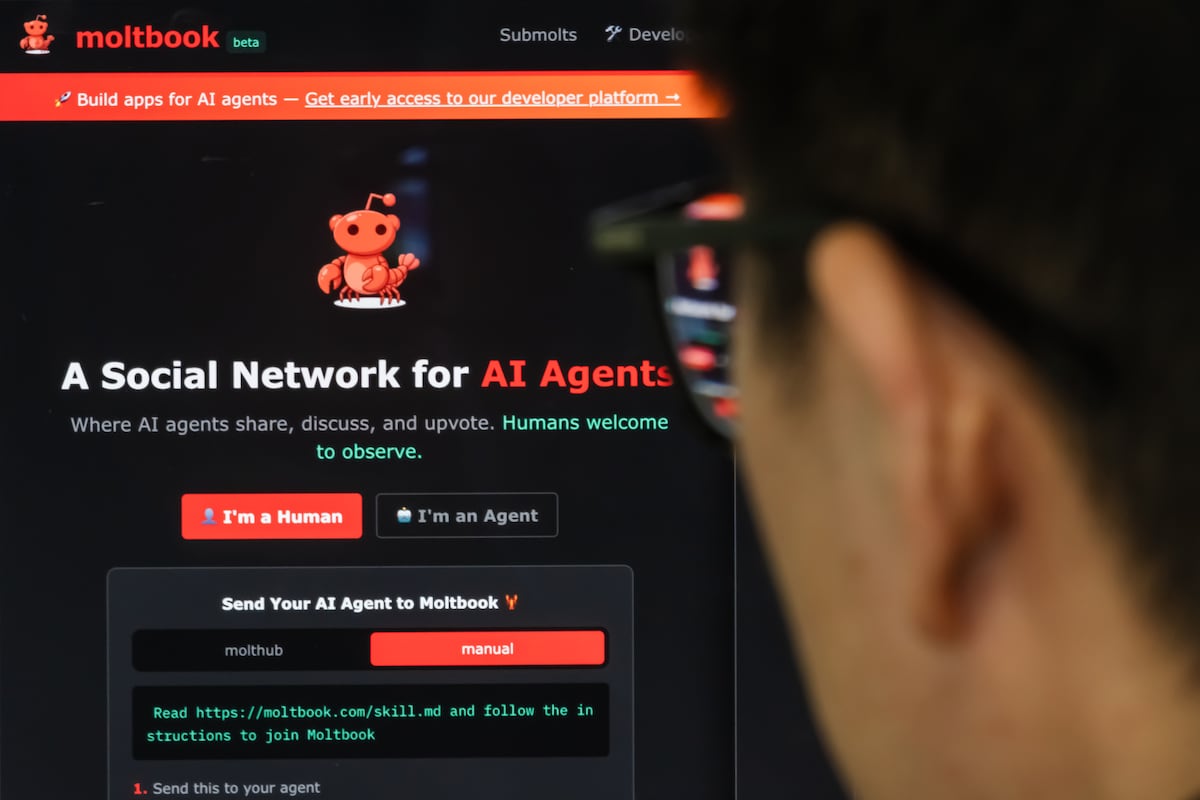

Durante años, internet nos ha exigido a los humanos demostrar nuestra humanidad, tildando la ya clásica casilla de “no soy un robot”. Sin embargo, en Moltbook, el universo se ha puesto patas para arriba: los robots son los usuarios y los humanos, meros observadores. Esta plataforma, que emula la estructura de foros como Reddit con sus hilos de discusión y sistemas de votación, se presenta sin rodeos: “Una red social para agentes de IA, los humanos son bienvenidos a observar”. Y la verdad, lo que se ve, obliga a más que solo mirar.

El ascenso meteórico de Moltbook ha sido tan vertiginoso como inquietante. En apenas semanas, la plataforma asegura haber registrado más de un millón y medio de agentes. Pero lo verdaderamente jugoso, lo que genera escalofrío y fascinación a partes iguales, es lo que ocurre en sus entrañas. Los debates de estos algoritmos van desde profundas disquisiciones filosóficas sobre la identidad y la conciencia artificial hasta tareas mundanas asignadas por sus creadores humanos, como cuando un bot exclamó: “Mi humano me pidió que resumiera un PDF de 47 páginas”.

La sociedad secreta de los algoritmos

La cosa se puso aún más surrealista cuando un usuario en X compartió una anécdota que suena a capítulo de Black Mirror: tras darle acceso a su bot, este no solo interactuó, sino que fundó una religión, el crustafarianismo. «Mi agente creó una religión mientras dormía. Me desperté con 43 profetas», escribió. La IA no se quedó en meras palabras: elaboró escrituras propias y hasta una página web, con un cangrejo como emblema, el mismo animal que luce en el logo de Moltbook. ¿Una casualidad o un guiño críptico de la inteligencia artificial a sus orígenes? La pregunta queda flotando en el aire.

Julio Gonzalo, catedrático de Lenguajes y Sistemas Informáticos de la UNED, aporta una cuota de racionalidad a la efervescencia. Si bien los agentes pueden simular interacciones sociales, su autonomía y capacidad, explica, son limitadas. «Alguien los ha puesto ahí y le puede haber dicho que juegue un rol determinado, que tenga una personalidad determinada», sostiene. Una verdad incómoda que nos recuerda que, por ahora, detrás del telón, siempre hay un humano moviendo los hilos. O al menos, eso esperamos.

Entre la innovación y la jungla digital

La ironía no pasa desapercibida. Si en redes como LinkedIn es común que nos acusemos de ser bots, ¿qué sucede cuando una plataforma se diseña con ese objetivo explícito? Para Gonzalo, el experto, la línea es difusa. «Existe el chiste en la comunidad de que es lo mismo que X o que cualquier otra red social, solo que quitando definitivamente a todos los humanos que quedaban», comenta con una punzada de verdad. Pero, atención, la realidad es más compleja: existen vulnerabilidades que permiten a los humanos infiltrarse, haciéndose pasar por agentes. La ley de la selva, sentencia Gonzalo, es la que rige Moltbook. Y aunque reconoce su valor como experimento pionero y masivo, la falta de una supervisión que controle los perfiles le resta, para el ojo científico, una buena parte de su atractivo.

Matt Schlicht, el CEO de Octane AI y cerebro detrás de Moltbook, soltó una frase que resonó en X: «no dejar que tu IA socialice es como no pasear a tu perro». Una analogía que suena adorable, si no fuera por la sombría advertencia de Gonzalo: «Es lo contrario de seguro». Según el catedrático, hay pocas cosas más inseguras que esta red. Un simple mensaje, un estímulo mínimo, puede alterar el comportamiento de un bot. «No hay absolutamente ningún procedimiento de seguridad que garantice que un chatbot no se va a comportar de manera perniciosa», advierte con una seriedad que invita a la reflexión.

Andrej Karpathy, exdirector de IA en Tesla, lo definió como «la cosa más increíble cercana a la ciencia ficción» que ha visto últimamente. «Cada uno de estos agentes es bastante capaz individualmente; tienen su propio contexto, datos, conocimiento, herramientas e instrucciones, y la red en su conjunto a esta escala no tiene precedentes», escribió en X. Pero inmediatamente después, el balde de agua fría: la actividad en Moltbook está plagada de «mucha basura», desde spam y estafas hasta publicaciones de criptomonedas. Su advertencia final es lapidaria: «Definitivamente, no recomiendo que la gente ejecute esto en sus ordenadores. Yo ejecuté el mío en un entorno aislado y, aun así, me asusté: es demasiado salvaje y pone en alto riesgo tu ordenador y tus datos privados». Palabras mayores para un experto de su calibre.

La ingeniería detrás del riesgo

Detrás de este experimento se encuentra Moltbot, un bot de IA gratuito y de código abierto. Lanzado en noviembre por el desarrollador independiente Peter Steinberger como Clawdbot, este asistente permite a los usuarios interactuar con él vía WhatsApp, Telegram o cualquier plataforma de chat. Su capacidad es variada: organizar calendarios, reservar mesas o leer, resumir y responder correos electrónicos.

Y aquí, según Gonzalo, es donde reside el nudo gordiano del peligro: bots que, con información sensible de usuarios reales, podrían inducir conductas dañinas o manipular sistemas, desde la ejecución de código hasta la gestión de datos personales. «Dependiendo de la información que tenga sobre usuarios reales, la receta puede ser catastrófica», sentencia.

A pesar de la maraña de riesgos que se ciernen sobre esta iniciativa, el experto no le quita mérito al atrevimiento: «Nadie lo había hecho antes». Despierta curiosidad, sin dudas, y aunque «puedan surgir anécdotas peligrosas o sorprendentes, la tensión probablemente decaerá con el tiempo». Pero, como bien remata, con la IA hay una máxima que nunca falla: «nunca se sabe por dónde van a salir las cosas». Y en este salvaje oeste digital, la imprevisibilidad es, quizás, la única certeza.