La inteligencia artificial (IA) se ha convertido en un arma de doble filo en el mundo de la ciberseguridad. Mientras que las fuerzas del orden registran un aumento del 3,4% en los ciberataques, la IA está siendo utilizada tanto por criminales para sofisticar sus ataques como por empresas para defenderse. Sin embargo, expertos advierten que la proliferación de ataques supera las defensas actuales, democratizando el acceso a herramientas maliciosas y permitiendo fraudes más elaborados y difíciles de detectar.

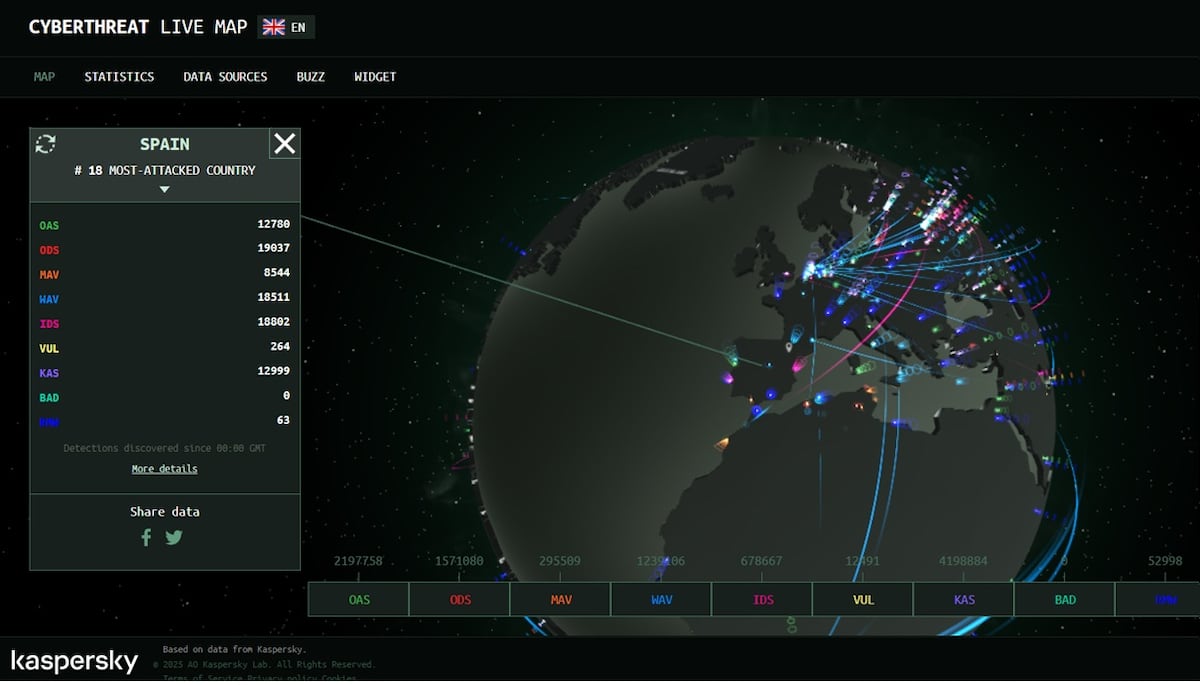

Cada minuto, un nuevo ciberataque sacude la red. Según el Balance de Criminalidad del Ministerio del Interior, las fuerzas policiales españolas registraron 245.191 golpes en los primeros seis meses del año, un incremento del 3,4% respecto al mismo período del año anterior. Y ojo, que estos son solo los casos denunciados. Muchos incidentes quedan en la sombra, ya sea para proteger la reputación de la entidad afectada o porque se resuelven internamente. Lo cierto es que uno de cada cinco delitos ocurre en el mundo digital, y la mayoría (86,4%) son estafas informáticas: más de 400.000 al año, un 488,3% más que hace nueve años. ¿El gran motor de este crecimiento? La inteligencia artificial (IA), capaz de acelerar, sofisticar y multiplicar los ataques, pero también, según Rafael López, ingeniero de seguridad en Check Point Software, de "democratizar" las armas cibernéticas, poniéndolas al alcance de atacantes con menos conocimientos técnicos por precios que oscilan entre 85 y 1.000 euros, con botines que pueden alcanzar el medio millón. ¿Estamos ante la tormenta perfecta?

El delito informático, en esencia, sigue siendo el mismo: robo, estafa, secuestro y extorsión. Lo que cambió es la facilidad para cometerlos. "La IA es actualmente más un acelerador de las técnicas existentes que algo que cambia fundamentalmente la naturaleza de los ataques. Algunos pueden ser más simples de realizar y, por lo tanto, más numerosos; sin embargo, la base de cómo detectar y responder a estos eventos sigue siendo la misma", explica Chris Betz, director de seguridad de la información de Amazon Web Services, al MIT Technology Review. Una declaración que suena a optimismo en medio del caos.

De esta manera, la IA se ha convertido en una herramienta tanto para los delincuentes como para los defensores. "Los agentes [de IA] también pueden desplegarse para detectar vulnerabilidades y protegerse contra intrusos", señala Edoardo Debenedetti, de la Escuela Politécnica Federal de Zúrich (Suiza), al mismo medio. Sin embargo, el aumento constante de los ataques sugiere que las defensas aún no están a la altura de la amenaza.

¿Un arma de doble filo?

Un estudio reciente de Daniel Kang, profesor asistente de la Universidad de Illinois Urbana-Champaign, revela que los agentes de IA actuales pueden "explotar con éxito hasta el 13% de las vulnerabilidades sin conocimiento previo" de los datos de la víctima, y un alarmante 25% si cuentan con un mínimo de información. Cifras que ponen los pelos de punta.

"La inteligencia artificial es un arma de doble filo y, ahora mismo, los cibercriminales la están utilizando de una manera masiva: son capaces de replicar páginas web por completo, hacer enlaces o incluso correos que son prácticamente perfectos", precisa Rafael López. No solo los típicos fraudes que suplantan alguna marca, añade, sino incluso para "lo que se llama la estafa del CEO, en la que te interceptan un correo legítimo o suplantan a una empresa y se ponen a hablar en nombre del directivo o de la persona que tiene que hacer los pagos". Un nivel de sofisticación que hace temblar hasta al más precavido.

"Las estafas que se están cometiendo últimamente persiguen un fraude de entre 90.000 y 100.000 euros", añade López. Una de las víctimas de este sistema fue una empresa de hostelería, víctima de una facturación falsa que, afortunadamente, Check Point pudo detectar a tiempo. ¿Pero cuántos casos similares quedan ocultos, engrosando las estadísticas silenciosas del cibercrimen?

La perfección como señal de alerta

El grado de perfeccionamiento de los ataques ha obligado a cambiar las medidas preventivas. Si antes se buscaban errores gramaticales como evidencia de un correo malicioso, ahora se recomienda lo contrario: "Si te llegó un correo que está demasiado bien escrito, sin faltas de ortografía ni gramaticales, seguramente lo ha escrito la inteligencia artificial. Duda de él", advierte el especialista en seguridad. ¿Paradójico? Tal vez, pero es el mundo en el que vivimos.

Según el informe de Threat Intelligence de Anthropic, la empresa detrás de Claude, "los ciberdelincuentes y los estafadores han incorporado la IA en todas las etapas de sus operaciones. Esto incluye perfilar a las víctimas, analizar datos robados, robar información de tarjetas de crédito y crear identidades falsas, lo que permite que las operaciones de fraude amplíen su alcance a más objetivos potenciales". Un panorama desolador.

El futuro incierto de la ciberseguridad

La IA incluso puede programar el ataque, configurar el código que infectará los sistemas. "Las herramientas comunes", matiza Marc Rivero, investigador jefe del Global Research & Analysis Team de Kaspersky, "tienen unos mecanismos de seguridad que impiden que tú le pidas ciertas cosas, pero se las puede engañar o montar entornos de forma local donde tú eres el amo y señor del castillo. Todo eso permite modificarlo a tu gusto y poder pedir lo que tú quieras sin ninguna restricción". ¿Estamos a las puertas de una nueva era en la guerra cibernética?

"En la nueva actualización de ChatGPT se han abordado de forma clara y sustancial los riesgos de sus malos usos implementando nuevas funciones para respuestas más seguras, mecanismos de detección y bloqueo de redes que intenten explotar el modelo con fines maliciosos, salvaguardas robustas para agentes autónomos que actúan en nombre del usuario, y la retirada proactiva de funcionalidades que podrían comprometer la privacidad o la seguridad. Aun así, ChatGPT, como cualquier otro asistente de inteligencia artificial, no es un sistema invulnerable y puede ser manipulado", advierte Hervé Lambert, director de operaciones en Panda Security. Un recordatorio de que, a pesar de los esfuerzos, la vulnerabilidad persiste.

"Los humanos cometen algún error", añade el especialista de Check Point. "Estos son caros, pero es cierto que hay fórmulas que lo democratizan; por ejemplo, hay plataformas de phishing [suplantación] o malware [programa malicioso] as a service que funcionan por suscripción, con su equipo de soporte por si tienes algún tipo de problema. Se contratan por uso y van desde los 200 o 300 dólares mensuales hasta los 12.000 o 13.000. Los malos funcionan ya como empresas", advierte. Un negocio redondo para el cibercrimen, sin duda.

Las cifras coinciden con el informe de Anthropic, que ha detectado programas de IA "para desarrollar, comercializar y distribuir variantes de ransomware [secuestro de datos y sistemas para exigir rescates], con capacidades avanzadas de evasión, cifrado y mecanismos antirrecuperación". ¿Estamos ante una escalada imparable?

"Ahora es tan sencillo y tan fácil conseguir este tipo de herramientas que se ha conseguido industrializar y automatizar. La IA no solo se usa para generar contenido, sino también para sistematizar y que sea mucho más rentable y sencillo ejecutar campañas masivas", resalta Rafael López. Un comentario que deja un sabor amargo.

Anthropic detectó una operación de robo y extorsión a gran escala tras acceder a datos personales de 17 organizaciones distintas, incluidas de atención médica, servicios de emergencia e instituciones gubernamentales y religiosas. En este caso, "la IA se utilizó para automatizar el reconocimiento, la recopilación de credenciales de las víctimas y la penetración en redes. El sistema de inteligencia artificial tomó decisiones tácticas y estratégicas, como decidir qué datos filtrar y cómo elaborar demandas de extorsión psicológicamente dirigidas". Un ejemplo escalofriante del potencial destructivo de la IA en manos equivocadas.

Esta compañía ha detectado incluso el uso de los nuevos sistemas para acceder a puestos de trabajo en entidades críticas. "La IA permitió crear identidades falsas con antecedentes profesionales convincentes, completar evaluaciones técnicas y de codificación durante el proceso de solicitud de empleo y entregar un trabajo técnico real una vez contratado". Un escenario digno de una película de ciencia ficción, pero que ya es una realidad.

Según el informe CyberArk Identity Security Landscape 2025 de CyberArk, estas "identidades invisibles" —es decir, cuentas de servicios, bots, agentes de IA, pipelines de desarrollo, etc.—, acceden a datos sensibles sin la supervisión ni los controles adecuados, convirtiéndose en el nuevo vector de riesgo más crítico. "El 94% de las empresas españolas ha sufrido ataques de suplantación, muchos de ellos potenciados por técnicas de deepfake [bulo con apariencia real], y el 60% de las organizaciones ha sido víctima en más de una ocasión", detalla el informe. "El acceso privilegiado que tienen los agentes de inteligencia artificial supone un riesgo estructural que las compañías aún no están gestionando con la urgencia que requiere", advierte la compañía. Una llamada de atención que no podemos ignorar.