Una adolescente de Nueva Jersey fue víctima de un ‘deepfake’ sexual generado con la app ClothOff por sus compañeros de instituto. La imagen, alterada con IA, se viralizó sin que los responsables fueran acusados penalmente. Ahora, la joven demanda a ClothOff, una empresa bielorrusa, con el objetivo de cerrar sus operaciones y frenar la imparable escalada de pornografía no consentida creada por inteligencia artificial, un flagelo digital que ya suma numerosos casos en España y el mundo.

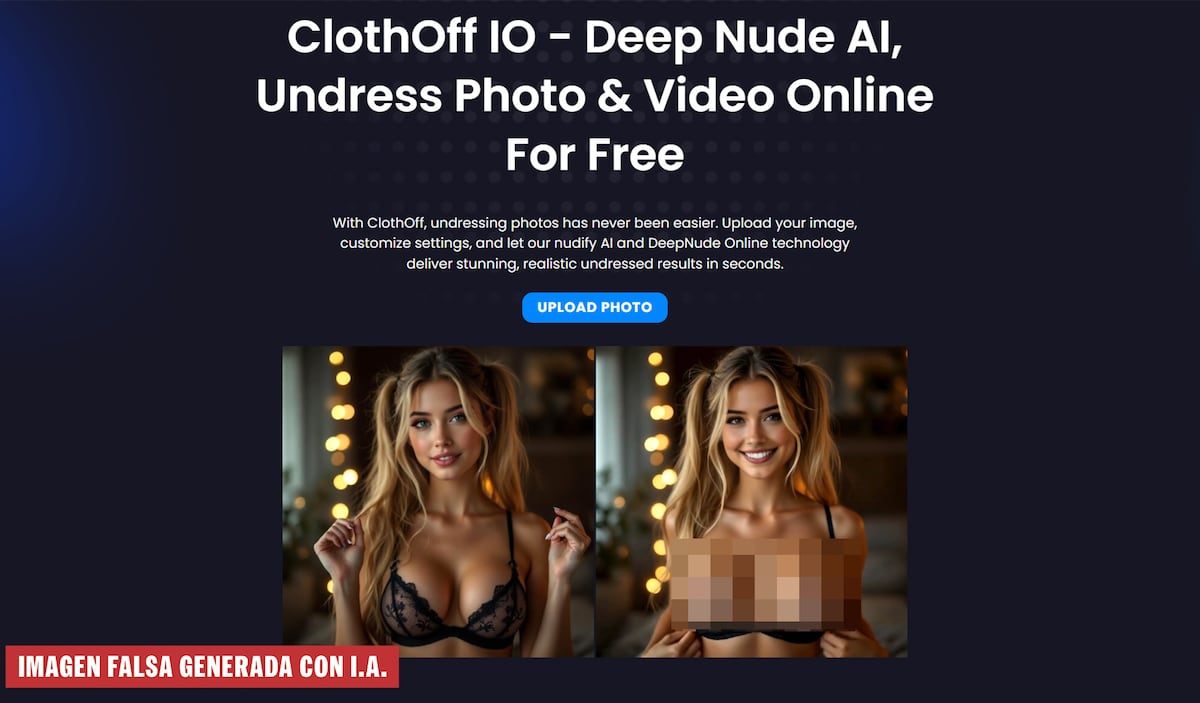

La inteligencia artificial nos prometía el futuro, pero a veces parece que nos trae el infierno en cuotas. O al menos, un infierno digital para las más jóvenes. El caso de una adolescente de 14 años en Nueva Jersey es el enésimo campanazo, un grito de alerta en medio del silencio cómplice o la parálisis legal que rodea a un fenómeno inquietante: los desnudos generados por IA sin consentimiento. En octubre de 2023, su vida cambió cuando unos jóvenes del instituto tomaron una foto de su Instagram, la pasaron por ClothOff –una aplicación que crea cuerpos desnudos con inteligencia artificial– y la distribuyeron por Snapchat.

Lo más grave, y lo que pinta un panorama desolador, es que los sospechosos no fueron acusados penalmente. ¿La razón? Se negaron a hablar o a ceder sus dispositivos a las autoridades. Una muestra de impunidad que deja a la víctima en un estado de "perpetuo miedo" a que su imagen falsa reviva en internet. Ante esta situación, la adolescente ha decidido llevar la batalla a otro nivel: demandar directamente a ClothOff, la empresa supuestamente radicada en Bielorrusia y que está detrás de una red de aplicaciones similares que desnudan con IA.

La demanda no es un detalle menor; pretende "cerrar definitivamente las operaciones de ClothOff", según Brina Harden, del Centro de Libertad de Medios y Acceso a la Información de la Universidad de Yale, parte del equipo legal. La acusación es contundente: "Esta empresa existe únicamente para sacar provecho de la explotación sexual y el abuso facilitados por la inteligencia artificial". Una afirmación que, a la luz de los hechos, suena más a una cruda verdad que a una mera denuncia legal.

La firma legal detalla cómo este negocio turbio no para de crecer. "Webs como ClothOff no hacen más que ganar alcance y popularidad", explica Harden, añadiendo nuevas funciones como vídeos de las víctimas o la posibilidad de colocar sus cuerpos en nuevas posturas sexuales. Las cifras que espantan: 27 millones de usuarios en los primeros meses de 2024 y la generación diaria de unas 200.000 imágenes. ¿El modelo de negocio? Suscripciones o compra de créditos. Un lucro obsceno a costa de la dignidad ajena.

El espejo español que nadie quiere mirar

La demanda estadounidense, con buen criterio, cita el caso español de Almendralejo, que se destapó apenas un mes antes. "Cuando nos pasó esto nadie sabía ni siquiera lo que era una deepfake”, relata Miriam Al Adib, ginecóloga y madre de una de las adolescentes afectadas en la ciudad extremeña. "Gracias a esa bomba mediática se tomaron en serio aquí las cosas porque al principio ni la policía sabía qué hacer con eso. Ahora al menos saben que se puede denunciar porque cuando nos atendieron el agente nos dijo que eso no era real, que era inteligencia artificial", añade. En Almendralejo, afortunadamente, los jóvenes fueron acusados de pornografía infantil e integridad moral. Mientras tanto, en EE UU, desde mayo tienen una ley específica contra la publicación de imágenes íntimas sin consentimiento, incluidas las generadas por IA.

"No sabía yo que se podía denunciar también directamente a la app", confiesa Al Adib, poniendo en evidencia la desorientación general ante esta nueva modalidad de ciberacoso. El objetivo de la cruzada legal en suelo americano es ambicioso: eliminar el acceso a estas aplicaciones en internet. "Si ganamos el caso, planeamos usar todos los medios posibles para hacer cumplir lo que ordene el tribunal, incluso pedir a los intermediarios que eliminen a ClothOff de sus plataformas", explica Harden. Una tarea titánica en la jungla digital.

Y es que no será una batalla fácil. Hay cientos, miles de anuncios y opciones de bots que usan IA para estos fines. Las redes sociales son un caldo de cultivo: en X, pululan mensajes como "No sé si esto es una genialidad o una locura, pero encontré una herramienta de IA que desnuda a la gente en las fotos. Es una pasada y da un poco de risa. Pruébala". Y el colmo del cinismo, añaden una suerte de advertencia al final, después del enlace: "Hazlo con cuidado". Reddit y Telegram también son plataformas donde proliferan comentarios y accesos a estos servicios, muchos vinculados a ClothOff, que, según la demanda, adquirió al menos 10 servicios similares con nombres como Undress AI Video, UndressHer, PornWorks, DeepNudeNow, Undress Love, DeepNudeAI, AI Porn o Nudify. Una verdadera red de depredadores digitales.

Desde el boom mediático de 2023 y de otros casos que han ido salpicando la actualidad, estas apps no han hecho más que "mejorar", como todo el sector de la IA: mejores imágenes, más opciones, posibilidad de añadir vídeos. Con búsquedas simples, es posible encontrar bots de Telegram que permiten gratis subir una foto y convertirla en cualquier imagen en una postura sexual. A pesar de pequeños contratiempos reportados por usuarios, ClothOff sigue accesible con ofertas sofisticadas, como una API, que permite automatizar el proceso de creación de contenido pornográfico sin intervención humana. La automatización del horror, podríamos decir.

El peligro de pornografía infantil y cualquier otro daño imaginable es palpable: "El acceso directo a la tecnología de ClothOff permite a los usuarios crear material de abuso sexual infantil y contenido íntimo no consentido, lo que da la posibilidad de generar contenidos más extremos y esquivar mejor los sistemas de detección. Ese acceso directo también ha dado lugar a la aparición de múltiples webs y aplicaciones imitadoras que facilitan crear el mismo tipo de material", advierte la denuncia. Una puerta abierta al abismo, sin filtros ni controles.

Algunos lugares como California o Italia dicen haber logrado impedir este año el acceso en sus territorios a algunas de estas aplicaciones. Parecen pequeñas victorias en una larga y desigual guerra. "ClothOff se diseñó para ser fácil de usar y totalmente anónimo", dice Harden. "Basta con tres clics para generar imágenes desnudas, y la web no pide ningún tipo de verificación de edad", añade. En las tendencias de Google, se puede ver el pico de otoño de 2023 en las búsquedas de ClothOff, pero las búsquedas por el nombre de la empresa o la expresión más genérica deepnude apenas han variado. El interés por "desnudar" a otros digitalmente no cede.

Un tsunami digital sin tregua

Los casos en España y en el mundo siguen ocurriendo con un goteo constante, transformándose en un patrón alarmante. En julio, un joven de 17 años residente en Valencia fue detenido por desnudar fotos sacadas de redes de 16 compañeras de instituto y amigas que habían subido a su perfil de Instagram. ¿Su objetivo? Presumir de pericia informática y sacar algunos ingresos. Lo mismo le ocurrió a un joven de 15 años en Palma, que desnudó las imágenes de cinco compañeras. También pasó en febrero con un grupo de jóvenes en un instituto de Barcelona. Y este mes de octubre, la policía japonesa ha detenido a un hombre de 31 años acusado de crear más de 20.000 imágenes de 262 mujeres, la mayoría famosas. Había ingresado unos 7.000 euros vendiendo acceso a esas imágenes falsas. El lucro y la vanidad, los motores de esta ignominia.

En 2024, una investigación del Guardian permitió descubrir que los creadores de ClothOff eran dos personas residentes en Bielorrusia, Alaiksandr Babichau y Dasha Babicheva. Un exempleado del grupo de empresas detrás de ClothOff contó este verano a Der Spiegel que todos sus empleados trabajan desde países que pertenecieron a la antigua Unión Soviética. También detalló campañas de marketing en varios países de unos 150.000 euros en canales de Telegram, foros como Reddit o 4chan. Según documentos de la compañía que vio el Spiegel, el objetivo de la app son "hombres entre 16 y 35 años" con intereses en videojuegos, memes de internet, ideas extremistas de derechas, misoginia y Andrew Tate, un influencer misógino detenido que está siendo juzgado por violación en Rumanía. Un perfil que define a la perfección el caldo de cultivo para la misoginia digital.

Y para rematar esta cadena de despropósitos, una muestra de cinismo brutal: una de las preguntas en la web de ClothOff es si "es seguro usar ClothOff". La respuesta solo tiene en cuenta la privacidad y seguridad de los usuarios, no de las víctimas que deben ver sus cuerpos tratados como mercancía: "Tus fotos se procesan de forma segura, sin guardarlas ni compartirlas, lo que la convierte en una de las plataformas más seguras para ‘desnudar’ fotos en línea. Nuestra herramienta deepnude online procesa tus archivos en la nube, sin almacenarlos ni compartirlos. Todo el contenido se borra automáticamente después de generarse". Un mensaje que, más allá de la tecnicidad, suena a burla y legitima la cosificación digital del cuerpo ajeno. La cosa, digámoslo sin tapujos, pinta muy mal.