El gobierno argentino (¡bah, como si no tuviéramos suficientes quilombos!) presentó un proyecto de ley para regular la inteligencia artificial. La cosa va de prohibiciones, permisos y multas, con el reconocimiento facial como vedette polémica. ¿Lo bueno? Se busca proteger al ciudadano. ¿Lo malo? Que a las autoridades parece que les van a poner penitencia con arroz si se mandan alguna macana. La pregunta del millón: ¿servirá de algo o será otro clavo en el ataúd de la privacidad?

El gobierno argentino se mete con la inteligencia artificial: ¿avance o retroceso?

El martes pasado, mientras usted se debatía entre el precio del dólar y la falta de figuritas del mundial, el Consejo de Ministros presentaba el «Anteproyecto de ley para el buen uso y la gobernanza de la inteligencia artificial (IA)». Sí, ley para los algoritmos. Como si a los políticos les faltaran cosas para regular.

El documento, que busca darle forma criolla al «Reglamento Europeo de Inteligencia Artificial», promete ponerle límites a la aplicación de esta tecnología. La pregunta que nos hacemos todos es: ¿será esto un paso adelante para proteger nuestros derechos, o una nueva forma de control estatal disfrazada de buenas intenciones?

### ¿De qué va la cosa?

El borrador del anteproyecto, disponible para que usted opine (si tiene ganas y tiempo, claro), clasifica las aplicaciones de IA en tres categorías: prohibidas, permitidas con supervisión, y libres como el viento. Dentro de las prohibidas, entran los sistemas que manipulan emociones, explotan vulnerabilidades o infieren raza y opiniones políticas. ¡Touché!

En la categoría de «alto riesgo», encontramos a la vedette de la polémica: el reconocimiento biométrico. Sí, ese sistema que te identifica por la cara, como en las películas de espías. La ley establecerá en qué casos excepcionales las autoridades podrán autorizar su uso. ¿Excepcionales? ¿Quién decide qué es excepcional? Ahí está la madre del borrego.

Por último, el resto de las aplicaciones se consideran de «bajo riesgo» y andarán sueltas por ahí, sin restricciones aparentes. ¿Será tan así? Permítame dudarlo.

### Reconocimiento facial: ¿ojo que todo lo ve o herramienta indispensable?

El reconocimiento facial ya se usa en algunas investigaciones policiales, pero ahora quieren regularlo con lupa. El anteproyecto de ley prohíbe su uso en tiempo real en espacios públicos, salvo en casos «estrictamente necesarios» definidos en el Anexo II: búsqueda de víctimas de secuestro, prevención de atentados terroristas, localización de sospechosos de delitos graves (terrorismo, trata, etc.).

La autoridad que quiera usar estos sistemas deberá pedir permiso a los juzgados de lo contencioso-administrativo, especificando motivos de urgencia, personas a identificar, ámbito geográfico y temporal, y hechos que justifican la solicitud. ¿Servirá esto para evitar abusos o solo burocratizará el trabajo de la policía? Habrá que ver.

### ¿Quién vigila a los vigilantes?

La Agencia Española de Supervisión de Inteligencia Artificial (Aesia) será la encargada de vigilar los algoritmos. Sin embargo, el tratamiento de datos biométricos correrá por cuenta de la Agencia Española de Protección de Datos (AEPD), los sistemas que afecten a la democracia serán competencia de la Junta Electoral Central, y los que incidan en la justicia dependerán del Consejo General del Poder Judicial.

Demasiada división, ¿no? ¿No será más fácil que cada uno haga lo que sabe y listo? Pero bueno, así somos los argentinos, nos encanta complicar las cosas.

### ¿Etiquetar o no etiquetar? Esa es la cuestión

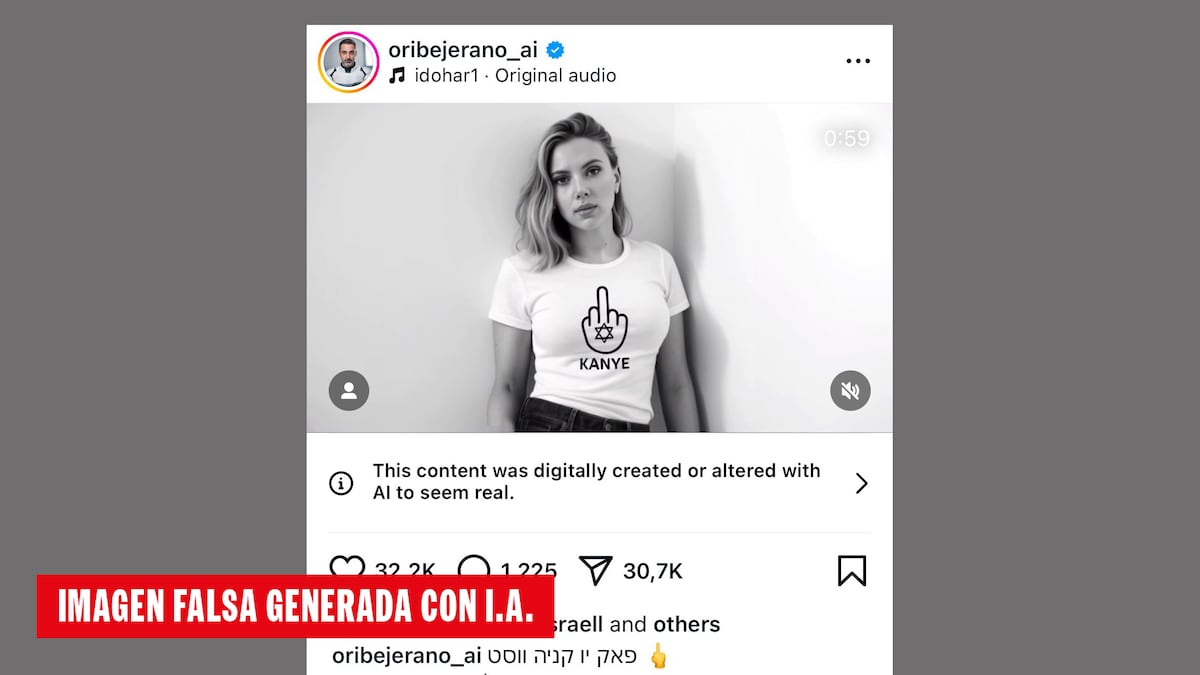

El anteproyecto de ley establece que «cuando los sistemas de IA generen contenido sintético de audio, imagen, video o texto», se deberá «marcar los resultados de salida de tal modo que pueda detectarse su naturaleza artificial». ¿Cómo? No se sabe. Pero si no lo hacés, te multan.

También será obligatorio informar a las personas que estén siendo sometidas a un sistema de reconocimiento de emociones o de categorización biométrica. O sea, si una cámara te está analizando la cara para ver si estás contento o triste, te tienen que avisar. ¿Y si no quiero que me analicen? ¿Puedo negarme? Preguntas, preguntas…

## Multas y castigos: ¿para todos o solo para algunos?

Las infracciones «muy graves» pueden costar entre 7,5 y 35 millones de euros (o entre el 2% y el 7% del volumen de negocios anual mundial). Las «graves», entre 7,5 y 15 millones de euros (o entre el 2% y el 3%). Y las «leves», entre 6.000 y 500.000 euros (o entre el 0,5% y el 1%).

Ahora bien, si la infracción la comete una autoridad pública, la cosa cambia. En ese caso, se apercibirá a la entidad actuante y se podrán establecer «las medidas que proceda adoptar para que cese la conducta o se corrijan los efectos de la infracción que se hubiese cometido, excluyendo la imposición de multas administrativas».

¿En serio? ¿A las autoridades no les ponen multa? ¿Qué clase de justicia es esta? Algunos juristas ya están poniendo el grito en el cielo. Y no es para menos. Acá parece que la ley es como la telaraña: atrapa a los mosquitos, pero deja pasar a los pájaros.

### ¿Una ley con doble vara?

El experto en derecho digital Borja Adsuara se queja, y con razón: «Con la IA pasará lo mismo», dice. «No conozco ni una sanción ni una amonestación a un funcionario o autoridad por un mal tratamiento de datos personales. ¿Para qué incluir en el anexo usos prohibidos por la Administración si no hay ninguna consecuencia?».

Y ahí está el quid de la cuestión. Si la ley no se aplica por igual para todos, no sirve para nada. Será solo un papel mojado, una declaración de buenas intenciones que, como tantas otras, terminará en el olvido.

En fin, el debate está abierto. ¿Usted qué opina? ¿Cree que esta ley será útil para regular la inteligencia artificial y proteger nuestros derechos? ¿O será solo otro intento fallido de controlar lo incontrolable? La tribuna es suya.