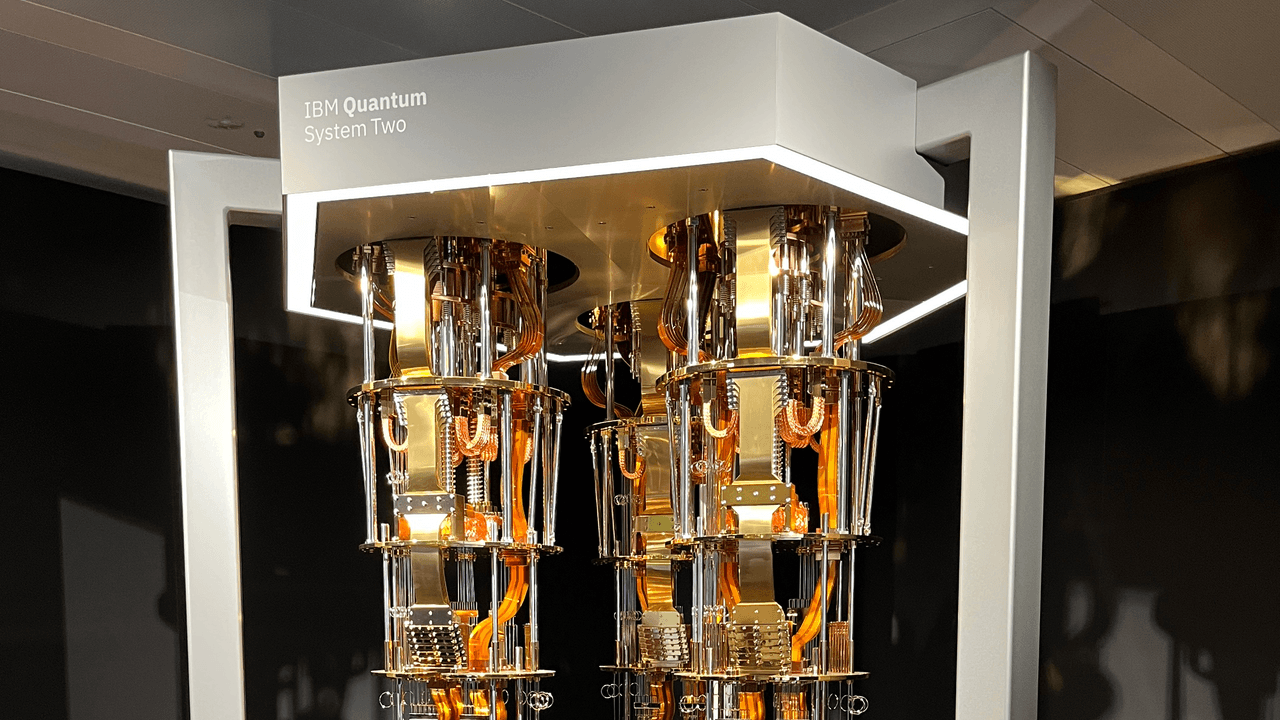

Mientras el ecosistema tecnológico aún intenta digerir la contundente irrupción de la inteligencia artificial generativa, los expertos ya avizoran el próximo hito “crítico”: la computación cuántica. Lo que hasta hace poco se percibía como una quimera futurista de contornos difusos, hoy ostenta una agenda precisa. IBM, con la audacia que la caracteriza, ha renovado su hoja de ruta para el desarrollo de estas máquinas, marcando en el calendario el año 2029 como fecha clave para una revolución que promete redefinir los límites de lo posible.

Para ese entonces, los equipos de investigación de la firma estadounidense proyectan materializar la primera computadora cuántica tolerante a fallos, un umbral que transformará el sector. Este logro no solo traslada la computación cuántica de los laboratorios a la esfera de la aplicación práctica, sino que también establece un precedente ineludible para la industria global.

El arribo de una era sin margen de error

La tolerancia a fallos, concepto medular en este avance, refiere a la capacidad inherente de una computadora cuántica para operar de forma continuada, incluso ante la inevitable aparición de errores en sus componentes. Los qubits, unidades fundamentales de información cuántica, son intrínsecamente frágiles y susceptibles a la pérdida de datos, cambios de estado o perturbaciones ambientales, lo que convierte la minimización de estos fallos en uno de los desafíos más formidables para los científicos.

Alessandro Curioni, director de IBM Research en Zúrich, delineó en un reciente encuentro con la prensa europea la magnitud del impacto práctico de esta innovación. Si las máquinas cuánticas actuales gestionan alrededor de 5.000 operaciones con una fiabilidad aceptable, la tolerancia a fallos elevará esa cifra a unos impresionantes 100 millones. Un salto exponencial que no solo es un número, sino la puerta de entrada a la plena explotación de las capacidades cuánticas.

No obstante, Curioni subrayó que la trascendencia de este avance se potencia exponencialmente al combinarse con el desarrollo de la Inteligencia Artificial. "Por primera vez, atestiguamos un escenario donde dos profundas innovaciones tecnológicas convergen de manera simultánea", explicó. "El influjo de los nuevos modelos de IA, sumado a la disponibilidad de computadoras cuánticas, devela horizontes inéditos".

Un nuevo paradigma para la resolución de enigmas

El factor dirimente, a juicio de Curioni, radica en la capacidad de ambas tecnologías para subvertir las bases de la informática computacional. "Tradicionalmente, el proceso implicaba analizar un problema ‘físico’, abstraerlo en una ecuación y obtener una solución, todo en una secuencia marcadamente lineal", detalló. "La IA ha reescrito este guion. Ahora es factible generar vastos modelos de inteligencia artificial, de los cuales se desprenden otros especializados, aptos para dilucidar problemas previamente inabordables".

Un fenómeno análogo se observa con la computación cuántica, la cual altera la representación misma de la realidad. Liberada de la lógica binaria tradicional, una computadora cuántica es capaz de modelar simultáneamente un sinfín de probabilidades. "Aquello que resultaba una quimera para el sistema de representación convencional, se simplifica drásticamente", sintetizó Curioni.

Sin embargo, es crucial una salvedad: la computación cuántica no se postula como la panacea universal. Existen tareas específicas donde el sistema binario conserva su primacía, particularmente en escenarios donde los cálculos involucrados no revisten una complejidad elevada.

Apelando a una metáfora atlética, el sistema tradicional emula a un velocista de cien metros: fulgurante en el corto aliento, pero exhausto frente a desafíos de envergadura. El sistema cuántico, en cambio, se asemeja a un maratonista, que despliega su verdadero potencial en las largas distancias, es decir, en los problemas de mayor intrincación.

"El verdadero salto cualitativo residirá en la conjunción de los tres pilares: modelos de IA, computación tradicional y computación cuántica. Esta sinergia permitirá alcanzar resultados que, por el momento, resultan incluso inimaginables", sentenció Curioni.

La competencia global por los algoritmos: ¿Dónde se jugará el Silicon Valley del mañana?

De cumplirse todos los pronósticos, el interrogante central radica en cómo capitalizar el vasto potencial de este nuevo panorama. Es aquí donde se dirimirá la contienda fundamental que moldeará el futuro, con claras implicancias geopolíticas para Europa. "En el escenario del desarrollo de hardware cuántico, Europa se encuentra en una posición desventajosa", explicó Curioni, "frente a la madurez alcanzada por empresas privadas estadounidenses [IBM y Google] y la Academia China de las Ciencias. No obstante, la verdadera pulseada se librará en el ámbito de las aplicaciones, donde existe un considerable margen para la inversión en implementaciones prácticas. Quienes logren desempeñarse con excelencia en esta arena, estarán en condiciones de forjar el nuevo Silicon Valley, y Europa puede, sin duda, ser protagonista de este ‘juego’".

En esencia, la consolidación de la informática cuántica, propiciada por máquinas tolerantes a fallos, inaugura una nueva era. Hasta ahora, los algoritmos se han gestado en un terreno de simulaciones y entornos de prueba sumamente acotados. La disponibilidad de una plataforma de hardware genuinamente confiable transformará radicalmente este escenario, permitiendo la verificación empírica de la eficacia real de las aplicaciones y abriendo un abanico de posibilidades hasta ahora inexploradas.

IBM actualiza su hoja de ruta en computación cuántica, proyectando la creación de la primera máquina tolerante a fallos para 2029. Este hito marcará la transición de la investigación a la aplicación práctica, multiplicando exponencialmente la capacidad de operaciones cuánticas. La convergencia con la inteligencia artificial se perfila como un factor catalizador, abriendo nuevos paradigmas para la resolución de problemas complejos y redefiniendo las bases de la informática computacional.

Resumen generado automáticamente por inteligencia artificial

Contenido humorístico generado por inteligencia artificial

Mientras el ecosistema tecnológico aún intenta digerir la contundente irrupción de la inteligencia artificial generativa, los expertos ya avizoran el próximo hito “crítico”: la computación cuántica. Lo que hasta hace poco se percibía como una quimera futurista de contornos difusos, hoy ostenta una agenda precisa. IBM, con la audacia que la caracteriza, ha renovado su hoja de ruta para el desarrollo de estas máquinas, marcando en el calendario el año 2029 como fecha clave para una revolución que promete redefinir los límites de lo posible.

Para ese entonces, los equipos de investigación de la firma estadounidense proyectan materializar la primera computadora cuántica tolerante a fallos, un umbral que transformará el sector. Este logro no solo traslada la computación cuántica de los laboratorios a la esfera de la aplicación práctica, sino que también establece un precedente ineludible para la industria global.

El arribo de una era sin margen de error

La tolerancia a fallos, concepto medular en este avance, refiere a la capacidad inherente de una computadora cuántica para operar de forma continuada, incluso ante la inevitable aparición de errores en sus componentes. Los qubits, unidades fundamentales de información cuántica, son intrínsecamente frágiles y susceptibles a la pérdida de datos, cambios de estado o perturbaciones ambientales, lo que convierte la minimización de estos fallos en uno de los desafíos más formidables para los científicos.

Alessandro Curioni, director de IBM Research en Zúrich, delineó en un reciente encuentro con la prensa europea la magnitud del impacto práctico de esta innovación. Si las máquinas cuánticas actuales gestionan alrededor de 5.000 operaciones con una fiabilidad aceptable, la tolerancia a fallos elevará esa cifra a unos impresionantes 100 millones. Un salto exponencial que no solo es un número, sino la puerta de entrada a la plena explotación de las capacidades cuánticas.

No obstante, Curioni subrayó que la trascendencia de este avance se potencia exponencialmente al combinarse con el desarrollo de la Inteligencia Artificial. "Por primera vez, atestiguamos un escenario donde dos profundas innovaciones tecnológicas convergen de manera simultánea", explicó. "El influjo de los nuevos modelos de IA, sumado a la disponibilidad de computadoras cuánticas, devela horizontes inéditos".

Un nuevo paradigma para la resolución de enigmas

El factor dirimente, a juicio de Curioni, radica en la capacidad de ambas tecnologías para subvertir las bases de la informática computacional. "Tradicionalmente, el proceso implicaba analizar un problema ‘físico’, abstraerlo en una ecuación y obtener una solución, todo en una secuencia marcadamente lineal", detalló. "La IA ha reescrito este guion. Ahora es factible generar vastos modelos de inteligencia artificial, de los cuales se desprenden otros especializados, aptos para dilucidar problemas previamente inabordables".

Un fenómeno análogo se observa con la computación cuántica, la cual altera la representación misma de la realidad. Liberada de la lógica binaria tradicional, una computadora cuántica es capaz de modelar simultáneamente un sinfín de probabilidades. "Aquello que resultaba una quimera para el sistema de representación convencional, se simplifica drásticamente", sintetizó Curioni.

Sin embargo, es crucial una salvedad: la computación cuántica no se postula como la panacea universal. Existen tareas específicas donde el sistema binario conserva su primacía, particularmente en escenarios donde los cálculos involucrados no revisten una complejidad elevada.

Apelando a una metáfora atlética, el sistema tradicional emula a un velocista de cien metros: fulgurante en el corto aliento, pero exhausto frente a desafíos de envergadura. El sistema cuántico, en cambio, se asemeja a un maratonista, que despliega su verdadero potencial en las largas distancias, es decir, en los problemas de mayor intrincación.

"El verdadero salto cualitativo residirá en la conjunción de los tres pilares: modelos de IA, computación tradicional y computación cuántica. Esta sinergia permitirá alcanzar resultados que, por el momento, resultan incluso inimaginables", sentenció Curioni.

La competencia global por los algoritmos: ¿Dónde se jugará el Silicon Valley del mañana?

De cumplirse todos los pronósticos, el interrogante central radica en cómo capitalizar el vasto potencial de este nuevo panorama. Es aquí donde se dirimirá la contienda fundamental que moldeará el futuro, con claras implicancias geopolíticas para Europa. "En el escenario del desarrollo de hardware cuántico, Europa se encuentra en una posición desventajosa", explicó Curioni, "frente a la madurez alcanzada por empresas privadas estadounidenses [IBM y Google] y la Academia China de las Ciencias. No obstante, la verdadera pulseada se librará en el ámbito de las aplicaciones, donde existe un considerable margen para la inversión en implementaciones prácticas. Quienes logren desempeñarse con excelencia en esta arena, estarán en condiciones de forjar el nuevo Silicon Valley, y Europa puede, sin duda, ser protagonista de este ‘juego’".

En esencia, la consolidación de la informática cuántica, propiciada por máquinas tolerantes a fallos, inaugura una nueva era. Hasta ahora, los algoritmos se han gestado en un terreno de simulaciones y entornos de prueba sumamente acotados. La disponibilidad de una plataforma de hardware genuinamente confiable transformará radicalmente este escenario, permitiendo la verificación empírica de la eficacia real de las aplicaciones y abriendo un abanico de posibilidades hasta ahora inexploradas.